R_Baayen のバックアップ(No.29)

- バックアップ一覧

- 差分 を表示

- 現在との差分 を表示

- ソース を表示

- R_Baayen へ行く。

- 1 (2007-09-26 (水) 15:54:15)

- 2 (2007-09-26 (水) 15:56:32)

- 3 (2007-09-27 (木) 12:15:19)

- 4 (2007-09-27 (木) 16:50:32)

- 5 (2007-09-28 (金) 13:06:17)

- 6 (2007-09-28 (金) 16:03:07)

- 7 (2007-09-29 (土) 15:38:01)

- 8 (2007-10-02 (火) 10:27:02)

- 9 (2007-10-06 (土) 12:07:20)

- 10 (2007-10-08 (月) 10:06:01)

- 11 (2007-10-12 (金) 11:27:15)

- 12 (2007-10-13 (土) 15:08:14)

- 13 (2007-10-29 (月) 10:36:58)

- 14 (2007-10-30 (火) 12:10:34)

- 15 (2008-03-12 (水) 18:17:13)

- 16 (2008-03-12 (水) 21:30:09)

- 17 (2008-11-21 (金) 10:13:43)

- 18 (2008-11-24 (月) 14:06:41)

- 19 (2008-12-29 (月) 18:45:27)

- 20 (2009-01-27 (火) 16:32:28)

- 21 (2009-02-03 (火) 12:28:20)

- 22 (2009-02-03 (火) 12:51:37)

- 23 (2009-02-04 (水) 14:55:48)

- 24 (2009-02-04 (水) 18:12:44)

- 25 (2009-02-04 (水) 19:27:57)

- 26 (2009-02-05 (木) 09:10:25)

- 27 (2009-03-25 (水) 14:55:38)

- 28 (2009-07-09 (木) 12:30:52)

- 29 (2009-07-10 (金) 18:21:56)

- 30 (2009-07-11 (土) 09:01:44)

- 31 (2015-10-17 (土) 11:23:28)

- 32 (2015-10-20 (火) 19:42:52)

- 33 (2015-10-22 (木) 06:08:25)

- 34 (2015-10-22 (木) 22:45:39)

- 35 (2015-10-23 (金) 14:48:28)

- 36 (2015-10-24 (土) 07:06:06)

- 37 (2015-10-24 (土) 23:21:24)

- 38 (2015-10-25 (日) 15:10:30)

- 39 (2015-10-26 (月) 06:41:27)

- 40 (2015-11-06 (金) 09:11:55)

- 41 (2015-11-09 (月) 16:46:04)

- 42 (2015-11-11 (水) 18:53:26)

- 43 (2015-11-20 (金) 18:42:28)

- 44 (2016-01-22 (金) 20:21:53)

- 45 (2016-05-12 (木) 17:54:54)

- 46 (2016-06-29 (水) 15:13:43)

- 47 (2016-08-13 (土) 20:39:38)

- 48 (2016-10-28 (金) 04:10:32)

- 49 (2016-10-28 (金) 07:37:20)

- 50 (2016-10-29 (土) 11:11:43)

- 51 (2016-10-30 (日) 12:49:05)

- 52 (2017-01-09 (月) 07:05:00)

- 53 (2017-01-20 (金) 08:57:12)

- 54 (2017-01-26 (木) 09:07:42)

- 55 (2017-05-21 (日) 04:59:52)

- 56 (2017-06-08 (木) 02:00:22)

- 57 (2017-06-08 (木) 09:19:44)

- 58 (2017-06-13 (火) 14:49:03)

- 59 (2017-06-15 (木) 09:05:10)

- 60 (2017-06-15 (木) 19:28:08)

- 61 (2017-06-16 (金) 02:25:05)

- 62 (2017-06-16 (金) 14:58:39)

- 63 (2017-06-17 (土) 12:43:32)

- 64 (2017-06-17 (土) 19:04:01)

- 65 (2017-06-18 (日) 00:38:54)

- 66 (2017-06-18 (日) 20:26:28)

- 67 (2017-06-20 (火) 15:40:37)

- 68 (2017-06-22 (木) 13:30:15)

- 69 (2017-07-30 (日) 05:09:10)

- 70 (2017-07-30 (日) 22:27:15)

- 71 (2017-08-11 (金) 21:23:34)

- 72 (2017-10-21 (土) 22:21:58)

- 73 (2018-02-17 (土) 13:41:14)

- 74 (2018-05-02 (水) 01:31:10)

- 75 (2018-05-12 (土) 18:52:34)

Baayen のAnalyzing Linguistic Data についての私的メモ

_ Baayen書評草稿

ある学会から依頼されて書いていた途中で止めた草稿.完成前に,編集委員ではない事務局の人が,なんだか妙な手続きをしてくれと言ってきたので,面倒になって書くのを中断してしまった.そういう Review.

_ 2008 11 24 以降のメモ

- テキストに表れるデータなんだが,説明が少なく,またlanguageRパッケージのヘルプも不十分なので,推測するのに苦労する.例えばdative データの AccessOfRec? 変数には水準が三つあるのだが,newとgivenはともかく,accesibleてのは何だったか? 思い出さないのでBresnan, J., Cueni, A., Nikitina, T. and Baayen, R. H. (2007) Predicting the dative alternation, in Bouma, G. and Kraemer, I. and Zwarts, J. (eds.), _Cognitive Foundations of Interpretation_, Royal Netherlands Academy of Sciences, 33 pages, in press. を読むしかないか.

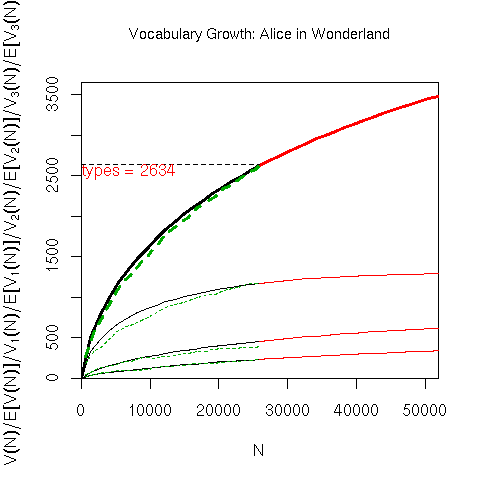

_ Baayen と言えば,語彙成長シミュレーションだと思われるので.

_ 以下は誤植あるいは誤解と思われる箇所.

ただし,草稿の段階なので,刊行された段階で修正されていると思われる.

- p.84

- ver.transp <- log(ver$...); ver.opaque <- log(ver$...)

- p.132

- splom(data.frame(affixes.pr$x[,1:3]),

- p.150

- ClesS と Ient との相関係数が有意とあるが,Cels と Vf の間違いではないか?

- p.155

- print.diana 関数に col = c("black","white") は意味ないのではないか?

- p.162

- accessibility of theme のカテゴリは given ではなく new.

- p.172

- spanish.manova <- manova(cbind(PC1, PC2, PC3, PC4, PC5, PC6, PC7, PC8) ~ spanishMeta$Author, data = spanish.x)

spanich データへの主成分分析の結果から,さらに判別分析を行うのに,CV = TRUE は使わないという節の理由が良く分からないのだが,何か見落としているだろうか?解決.主成分分析そのものを leave-one-out してから,その結果を使って lda をしろということ.

- p.177

- cbind(c(153, 342 - 153), c(202, 342 - 202))の間違いでは?

- p.184

- without including a main effect for meanFamiliarity^2 の間違では?

- p.213

- 下から5行目の 0.003 は 0.002 と思われる.

- p.229

Irregular verbs also tends to be more frequent than regular verbs, and it is reasonable to assume that this high frequnecy protects irregular verbs through time against regularization.

- p.243

- lines(local.subset$year, local.subset$predict, lty = 3)

- lines(local.subset$year, local.subset$predictA, lty = 3)

- p.255

- plot(alice.spc, lnre.spc(alice.lnre.$&color(red){gigp}, 25942))

- p.264

- lexdec データの初出は2章 p. 26.

- p.270

- pvals.fnc(lexdec3.lmer) で良い.$fitted は不要.

- p.274

- ranefs <- ranef(lexdec3.lmerD)

- p.275

- plot(ranefs$Subject)

_ Herdan の C

金先生より,languageRの関数growth.fnc()の出力はおかしいとうかがい,私も調べてみた.

languageR パッケージの growth.fnc () 関数の出力で,Herdan の C の計算方法は logV(N)/logN ではないよう.

data(alice) alice.growth <- growth.fnc(alice) alice.growth Chunk Tokens Types ... Herdan 1 1 646 269 0.7392036 log(269)/log(646) [1] 0.864609

そこでlanguageR パッケージのgrowth.fnc()を見ると herdan.fnc() を呼び出している.中を調べてみると,タイプ数の対数を最小二乗法を使って推定している. すなわち Chunk1の計算では,Chunk1までのトークン数1:646 の区間を,さらに指定のチャンク数を使って,floor(646/40) =16 間隔で区切り,この細かい区間でのタイプ数を数えている.そして,これらのベクトルに lm を適用している.

types <- c(16, 29, 40, 48, 56, 66, 77, 86, 94, 101, 109, 116, 124 ,130, 134, 140, 147, 150, 155, 161, 164, 166, 173, 177, 184, 191, 198, 203, 208, 210, 218, 224 ,229, 238, 243, 249, 255, 258, 264, 266) tokens <- c(16, 32 ,48 ,64, 80 ,96 ,112, 128 ,144, 160, 176, 192, 208, 224, 240, 256, 272, 288 ,304, 320 ,336, 352, 368, 384, 400 ,416, 432 ,448 ,464, 480, 496 ,512, 528, 544, 560, 576, 592, 608, 624, 640) coef(lm(log(types)~log(tokens)))[2]

端数を切り落としいる cumsum(rep(floor(length(text[1:chunks[i]])/40), 40))ので growth.fnc() 関数の出力に

Chunk Tokens Types 1 1 646 269

とあっても,Chunk1の計算に使っているのは,640 Tokensまでの情報.